在《【chatGPT】学习笔记27-提示词解读3-实战案例之摘要总结》中,我们演示了LLM的总结能力。

接下来,我们继续跟着吴恩达老师的课程,解锁LLM另一个更强大的能力——推理(Inferring)。

本文的“推理”是指利用LLM处理推理型的任务。

1.激发推理能力的提示词

(1)什么是LLM的推理能力

LLM的推理能力是指从已知信息中推导出新的结论的能力。

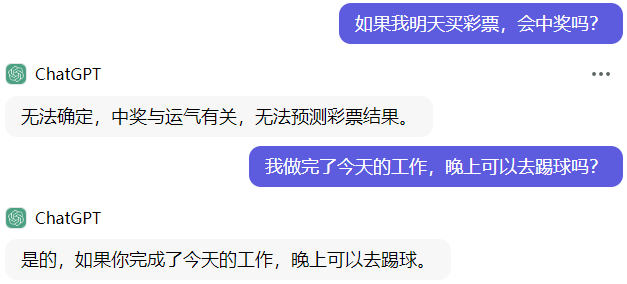

例如在下面的例子中,LLM根据上下文理解用户意图,经过推理生成了新的信息,包括结论和相应的解释。

(2)如何激发LLM的推理能力

我们可以这样构建提示词:

使用清晰明确的指令词,让LLM理解做什么类型的推理任务,如判断xxx、预测xxx。

提供足够的上下文信息,让LLM知道要处理的内容。

2.实战案例

假设我是某智能问答系统的IT人员,要用LLM的推理能力帮忙做运营维护:

- 判断用户对问答系统是否满意。

- 用户问题千奇百怪,让智能客服能够应对各式花样提问。

2.1.满意度识别

一般问答系统都希望通过点赞👍/点踩👎按钮获取用户的反馈,但大部分用户都不会去点。

利用LLM的推理能力,直接拿用户的对话信息来做满意度分析,可以大大提升运营效率。

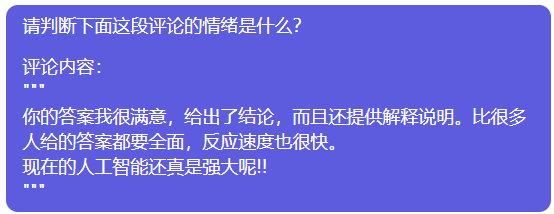

例如,让LLM判断用户回复的信息是什么感情色彩:

- 我的提示词如下:

- LLM的回答如下:

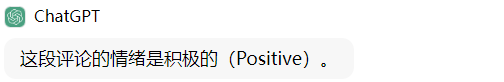

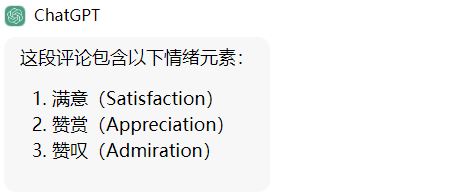

吴恩达老师"提示词工程课程"中说LLM擅长做情感判断,所以我又试了下让LLM列出评论中包含的情绪元素。看来LLM感情还是挺丰富的。

- 我的提示词如下:

- LLM的回答如下:

2.2.应对花式提问

传统智能问答系统是建立在知识库基础上的,通过关键词匹配最相关的答案,语义理解和推理能力非常有限。

现实用户提问方式五花八门,如果某个问题不在知识库,系统将无法提供准确答案。

基于LLM的推理能力,我们通过2个技巧快速提升智能问答系统的应对能力。

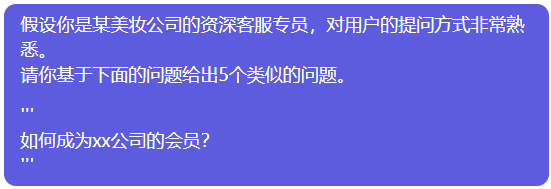

技巧1:基于已知问题推导类似问题

基于知识库中的预置问题,利用LLM推导扩充不同的问法,丰富问题集,同时弥补传统问答系统语义理解的不足。

- 我的提示词如下:

- LLM的回答如下:

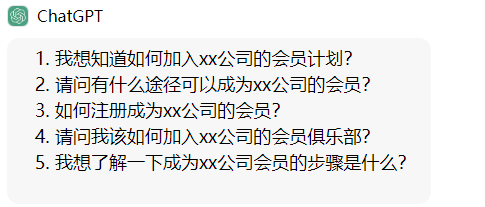

技巧2:归纳推理

上面的方法可能仍然不足以完全应对用户问题的多样性,那么可以继续用LLM来补漏。

利用LLM的归纳推理能力,将用户问题和系统关键词检索出的相关问题做比较,从语义上判断是否相近。

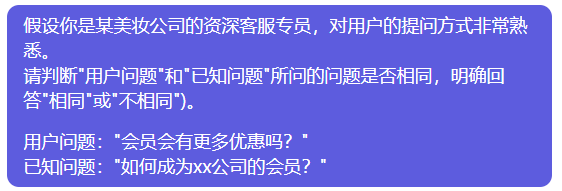

- 我的提示词如下:

- LLM的回答如下:

换个相关但不相近的问题–都有关键词”会员“但语义不同,LLM仍然回答正确,看来LLM的推理能力还是可靠的。

- 我的提示词如下:

- LLM的回答如下:

- 综上,利用LLM推导和归纳推理这两个技巧,可以实现快速扩充知识库、增强检索能力。

3.小结

本文介绍了一个LLM另一个实用的提示词技巧,解锁大语言模型的推理能力,充分利用大模型的智慧。

推理提示词的构建方法:

- 使用清晰明确的指令词,让LLM理解做什么类型的推理任务,如判断xxx、预测xxx。

- 提供足够的上下文信息,让LLM知道要处理的内容。