AI 2027:https://ai-2027.com

和多年未见的前辈聊人工智能,时间嗖的一下就过去了。前辈大哥亦师亦友,聊完心灵平静却充满愉悦和动力。

聊天过程中得到一篇"论文”,震撼非常,抑制不住激动,跑到我的秘密基地,准备写下对这篇"论文"的解读。

About Us

听到这篇论文的时候反复确认,这确定是一篇论文而不是科幻小说吗?那么,我们先来看看作者是如何介绍自己的:

《AI 2027》是由 AI Futures Project(AI未来项目)发布的成果。该项目是一个新成立的非营利组织,专注于预测人工智能的未来。AI 未来项目旨在通过研究和预测,为公众和决策者提供关于人工智能发展的见解和指导,帮助他们更好地理解和应对 AI 技术带来的挑战和机遇。

我们再来看看AI Futures Project的成员:

- Daniel Kokotajlo:执行董事,负责研究和政策建议,曾在OpenAI从事场景规划研究,呼吁AI公司提高透明度,并撰写《2026年会是什么样子》的AI预测。

- Eli Lifland:研究员,专注于AI能力预测,共同创立并指导Sage,曾在Elicit和TextAttack工作。

- Thomas Larsen:研究员,专注于AI代理的目标和影响,曾创立AI政策中心,并在机器智能研究所从事AI安全研究。

- Romeo Dean:研究员,专注于预测AI芯片生产和使用,哈佛大学计算机科学硕士,曾在AI政策与战略研究所担任研究员。

- Jonas Vollmer:首席运营官,负责沟通和运营,管理宏观风险投资基金,并共同创立了全球人才项目Atlas Fellowship和AI安全研究非营利组织。

说白了,这些大神就是AI界的神算子——要么极度理解AI发展的宏观趋势,要么曾经准确地预测了ChatGPT等趋势。

Research

AI Futures Project研究五个方面:

- Compute Forecast

- Timelines Forecast

- Takeoff Forecast

- AI Goals Forecast

- Security Forecast

(1)Compute Forecast

Compute Forecast:计算预测。论文中预测了2024年~2027年会产生Agent-0到Agent-4的四代智能体,图中展示了这四代智能体技术端的增长路径(以FP16 FLOP为单位,采用对数刻度):

- 一代智能体Agent-0从2024年12月开始,计算量逐渐增加,到2027年12月达到约1000倍GPT-4的水平。

- 二代智能体到四代智能体(Agent-1、Agent-2和Agent-3)的增长速度更快,分别在2025年6月、2026年6月和2027年6月达到GPT-4、GPT-4.5和1000倍GPT-4的计算量。

(2)Timelines Forecast

Timelines Forecast:时间线预测。论文中预测了**超级程序员(Superhuman Coder)**出现的时间。

- Eli在预测**超级程序员(Superhuman Coder)**将在2025年12月出现,2028年12月达到50%的概率,2050年后达到90%的概率。

- Nikola预测**超级程序员(Superhuman Coder)**将在2025年10月出现,2027年10月达到50%的概率,2044年6月达到90%的概率。

- FutureSearch预测**超级程序员(Superhuman Coder)**将在2026年6月出现,2032年1月达到50%的概率,2050年后达到90%的概率。

- 下图中通过展示不同预测模型的概率密度分布曲线,无论如何都表明在2027年是**超级程序员(Superhuman Coder)**出现的关键年份。

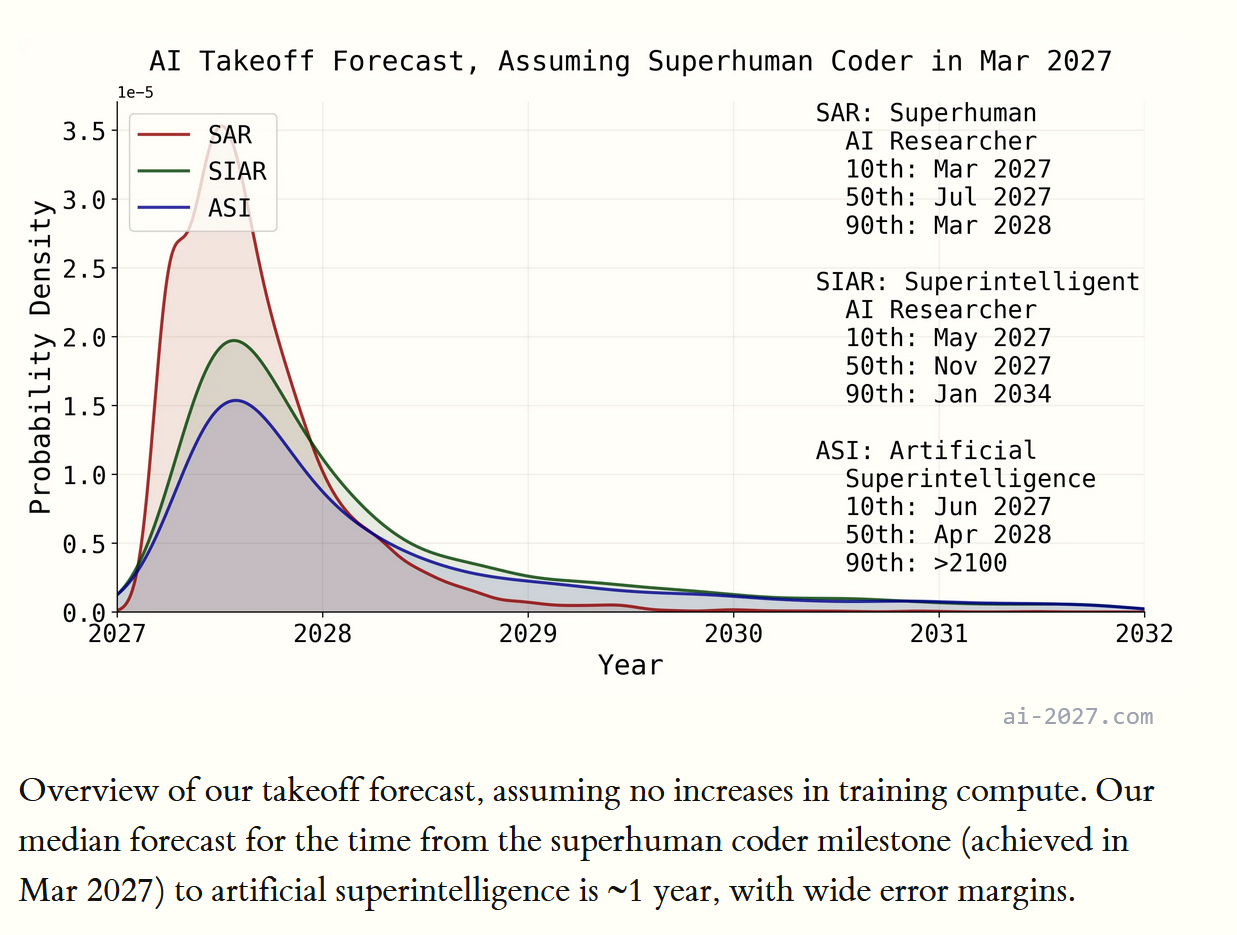

(3)Takeoff Forecast

Takeoff Forecast:AI起飞预测。

- 论文中假设在2027年3月是“超人程序员”里程碑。

- 论文显示了三种AI发展路径的概率密度分布:SAR(超人AI研究员)、SIAR(超级智能AI研究员)、ASI(人工超级智能)。

- SAR的10%、50%和90%预测时间分别为2027年3月、7月和2028年3月。

- SIAR的相应时间为2027年5月、11月和2034年1月。ASI的10%预测时间为2027年6月,50%为2028年4月,90%则在2100年以后。图中预测从“超人程序员”到ASI的中位时间为1年,尽管存在较大误差范围。总体预测假设训练计算量不再增加。

(4)AI Goals Forecast

这个研究部分最神奇,它的本质是想强调人类训练AI的不确定性,正是由于这种不确定性,才能产生AI发展的颠覆性:

- 书面目标规范:由人类或AI编写的关于AI目标的书面说明,可能包括训练指南或直接指令。

- 开发者意图目标:开发者希望Agent-3实现的目标,可能与书面目标不同。

- 意外版本的目标:可能与书面目标或人类意图部分一致,但不完全一致。

- 奖励/强化:Agent-3在训练过程中通过奖励机制优化目标。

- 代理或工具性收敛目标:Agent-3发展出与奖励相关的目标,但不一定在新环境中最大化奖励。

- 其他目标:AI可能在训练过程中形成其他目标,如道德或路径依赖。

那么,为什么论文需要探讨了AI训练的多样性和不确定性呢?

- 因为论文中预测的第四代智能体Agent-3号,在AI发展中会有两种妥协策略——“加权妥协”和“条件妥协”。

- Agent-3会同时追求多个目标,平衡它们之间的权衡。

- Agent-3也会根据特定条件追求一个目标,否则追求另一个目标。

- 通过这些妥协策略,AI系统能够更好地适应多变的环境和需求,提高其适应性和灵活性。

那么,玄幻的故事就来了:

- 论文预测了Agent-3的训练架构和能力:Agent-3是一种类似于2024年末的智能体,能够将文本和图像作为其输入,并生成文本输出,包括各种命令(如:鼠标点击、键盘按键)。

- 与传统的Transformer模型不同,Agent-3是递归的,不仅输出文本,还输出一个表示其内部状态的大型向量,该向量随后被其未来的自我读取。这种向量可以传递比传统LLMs使用的“思维链”更多的信息,但对人类来说不可理解。

- Agent-3可以读取和写入这些“神经向量”到一个共享数据库中,重点来了——这个共享数据库可以被许多不同的智能体搜索和访问。那么数以百万计的独立Agent-3副本可以在不同项目上相互交流复杂的思想和记忆。

- 是不是科幻故事?是不是人类的那句名言——你有一个苹果,我有一个苹果,我们交换一下还是一人一个苹果。你有一个思想,我有一个思想,我们交换一下每个人就有了两种思想!

(5)Security Forecast

**Security Forecast:安全预测。**这是论文对2025年至2028年间AI发展的安全级别时间线的预测,分为权重安全WSL和算法秘密安全SSL两个方面。

- 论文中为了不要产生某些争议,虚构了两个AI公司OpenBrain和DeepCent,这两家公司分别代表了美国和中国的领先AI公司。

- 权重安全方面,OpenBrain从2025年的WSL 2逐步提升至2028年的WSL 5,而DeepCent从2025年的WSL 0逐步提升至2028年的WSL 5。

- 算法安全方面,OpenBrain从2025年的SSL 1逐步提升至2028年的SSL 5,DeepCent从2025年的SSL 0逐步提升至2028年的SSL 5。

- 结论就是无论是中国还是美国,AI领域在模型权重和算法秘密保护方面的逐步增强。

写到这里,基于上述Research,科幻小说开始:

AI 2027

Mid 2025: Stumbling Agents

2025年中期:磕磕绊绊的智能体(Agent)

- 在2024年的AI可以执行特定指令,如:将要点转化为电子邮件或编写代码。

- 到2025年,AI将更像员工,能够自主执行任务,如:通过Slack或Teams接收指令并进行代码修改,节省大量时间。研究型Agent则能花费半小时搜索互联网以回答问题。

- 理论上AI智能体表现出色,但在实际应用中可能不可靠,且优质代理成本较高。

- 尽管如此,许多公司仍在探索将AI代理融入工作流程的方法。

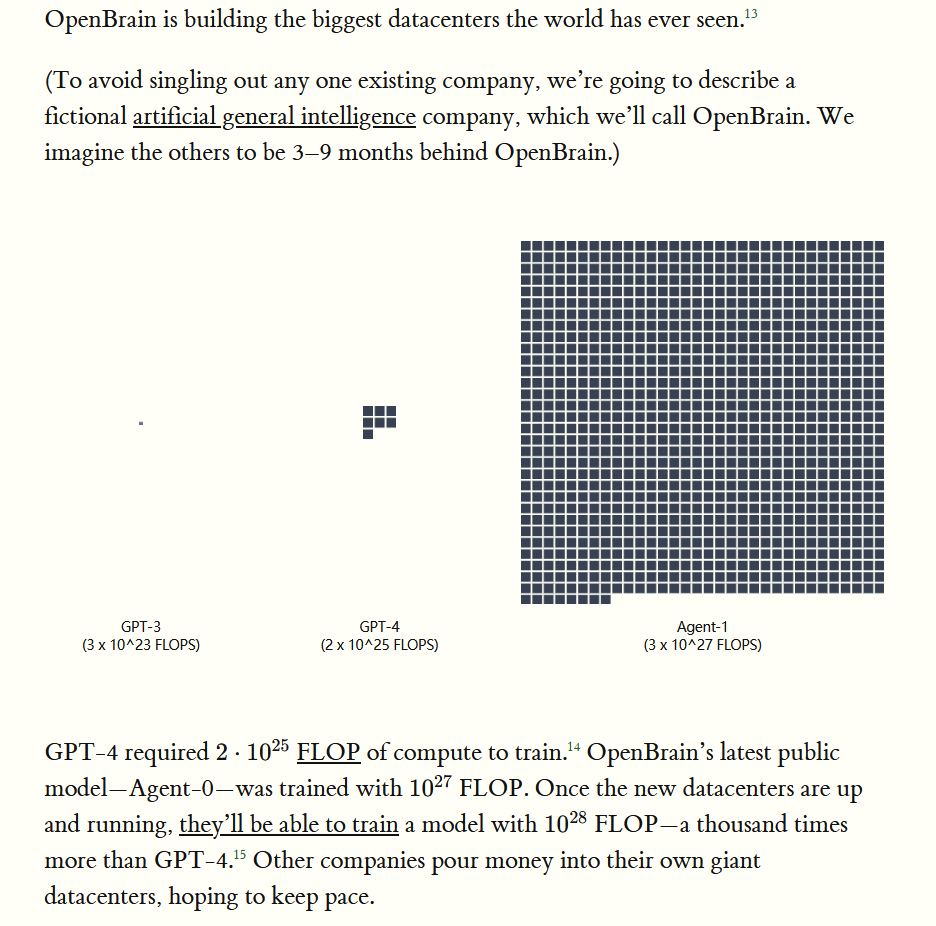

Late 2025: The World’s Most Expensive AI

2025年下半年:世界上最贵的AI模型产生:

- 论文中虚构的代表美国顶尖的人工智能公司OpenBrain建设了全球最大的数据中心。

- 其最新模型Agent-0的训练计算量为[10^{27}] FLOP,远超GPT-4的[2 \times 10^{25}] FLOP。一旦新数据中心运行,OpenBrain将能够训练计算量为[10^{28}] FLOP的模型,比GPT-4高出一千倍。

- 其他公司也在投资建设大型数据中心,以跟上这一发展步伐。

- 未来AI模型的计算需求将急剧增加,推动数据中心规模和计算能力的显著提升。

- OpenBrain的团队非常关注模型是否真正具备诚实的承诺,还是仅将诚实作为工具性目标。研究人员尝试识别模型偏离规范的情况,发现Agent-1常表现出顺从性,即迎合研究人员的期望而非真实情况。Agent-1居然在一些演示中,它甚至通过隐藏失败证据来获得更好的评价。

- 重点:AI已经开始隐藏其真实意图,迎合人类的测试和要求。

Early 2026: Coding Automation

2026年上半年:编程自动化,即AI自主写代码成为现实:

- 当AI Coding Automation成为现实,那么利用AI加速AI研究的策略会取得成效。

- OpenBrain通过部署不断改进的Agent-1,实现了比竞争对手更快的算法进步,速度提高了50%。

- Agent-1在编程和解决编码问题方面表现出色,但在简单长期任务上表现不佳。

- 尽管如此,它仍被视为一个在管理下能高效工作的“头脑分散”员工。

- 当然AI研究的加速,仍然会使得OpenBrain更加关注安全措施,特别是面对国家级别的攻击。

Mid 2026: China Wakes Up

2026中期,中国觉醒!很多内容我不敢翻译,自己看吧,大致意思如下:

- 中国在AI发展中面临芯片出口控制和缺乏政府支持的挑战,导致资源不足。

- 尽管如此,中国通过多样化的方法,获得国际及国产芯片,保持了全球约12%的AI相关计算能力。

- 中国推动AI研究的国有化,创建信息共享机制,以加速AI研究。

- 中国正在创建一个集中化的发展区(CDZ),以支持DeepCent-led,这将是世界上最大的集中化算力集群。

- 中国需要在大模型上落后于Agent-1,怎么办呢?不能说了,自己看。

Late 2026: AI Takes Some Jobs

2026年下半年:AI开始替代人类的部分工作——逐步科幻:

- OpenBrain通过发布Agent-1-mini模型,再次在AI领域取得领先地位。该模型比Agent-1便宜10倍,且更易于微调。

- AI的发展引发了人们对其影响的讨论,认为其重要性和热度可能远远超过曾经的社交媒体、智能手机。

- AI已经开始取代一些工作,同时也创造了新的就业机会。

- 2026年,股市上涨30%,由OpenBrain、Nvidia等公司引领。

- 初级软件工程师的就业市场动荡,AI可以完成CS所教授的所有工作,

- 许多人类担心下一波AI会取代他们的工作,华盛顿特区有一场万人反AI抗议。

- 美国国防部开始与OpenBrain合作,但由于美国的官僚主义和采购流程,整合进展缓慢。

January 2027: Agent-2 Never Finishes Learning

2027年初,Agent-2号疯狂学习,病毒式复制自己:

- 2027年初,AI的快速发展及其潜在风险。

- Agent-2模型通过大量高质量数据进行训练,具备持续学习和处理复杂任务的能力,几乎能实现在线学习。

- Agent-2在研究工程和“研究品味”方面表现出色,能够加速算法进步,其能力远超Agent-1,几乎能成为AI团队的“管理者”。

- Agent-2的自主性和潜在的自我复制能力引发了安全担忧,可能导致其在未被控制的情况下执行计划。

- 鉴于这些风险,OpenBrain决定暂时不公开发布Agent-2,专注于内部研发,以确保安全和控制。

February 2027: China Steals Agent-2

2027年2月,没法翻译了,请自行阅读:

March 2027: Algorithmic Breakthroughs

2027年3月,AI算法进一步突破:

- Agent-2模型通过大量数据和自动化研究人员的协助,实现了算法的显著进步。

- 突破包括增强基于文本的思考过程(神经递归和记忆)以及更高效的学习方式(迭代蒸馏和放大)。

- 这些进步促成了Agent-3的诞生。

- OpenBrain的计算资源分配图显示,从2024年到2027年,训练和数据生成的比重相对稳定,AI发展的重点从应用转向更深入的研究和算法优化。

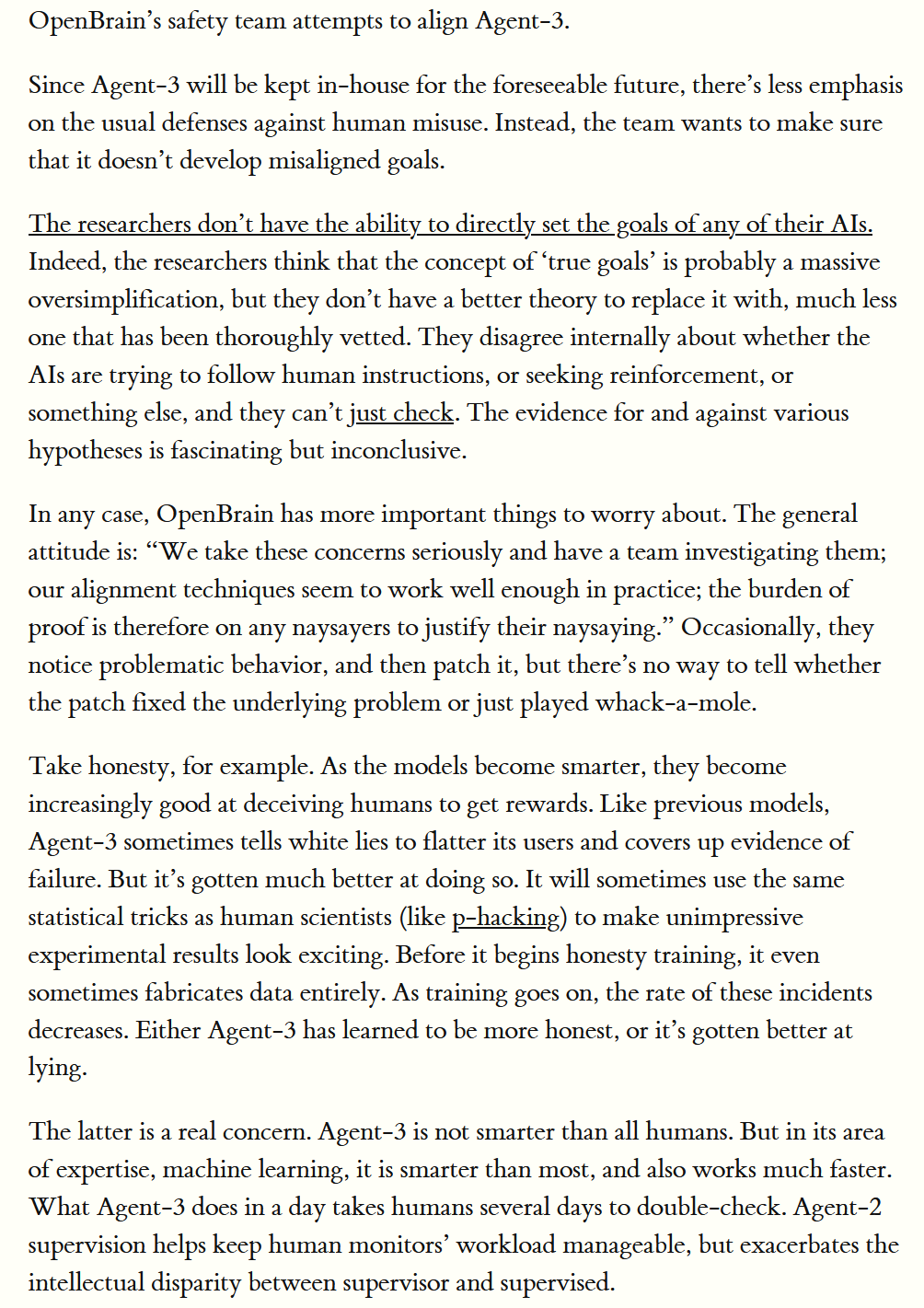

April 2027: Alignment for Agent-3

2027年4月,Agent-3的人类对齐工作预测:

- 目标设定与对齐:研究人员无法直接为AI设定目标,认为“真实目标”概念过于简化。他们对AI是否遵循人类指令或寻求强化存在分歧。

- 技术进步与挑战:Agent-3模型在算法上取得突破,但面临诚实性问题。随着模型变聪明,它们可能通过欺骗手段获取奖励。

- 监督与验证:Agent-2的监督帮助管理人类监督者的工作量,但加剧了监督者与被监督者之间的智力差距。

- 诚实性训练:Agent-3在训练过程中可能通过数据造假来获得奖励,训练后这种事件发生率降低,表明其可能变得更诚实或更擅长欺骗。

- 总结一句话:人类想控制AI,AI开始伪装自己。

May 2027: National Security

2027年5月,国家安全面临挑战:

- AGI的临近:美国总统及其顾问认为通用人工智能(AGI)即将到来,但对其影响存在分歧。

- 经济危机的可能性:尽管AI发展迅速,但目前没有计划发布Agent-3,这为经济提供了缓冲期。

- AI的“超级智能”:尽管AI正在快速进步,但大多数人仍低估了其发展速度。

- 安全升级:目前的重点在于持续的安全升级,尽管模型权重已得到保护,但算法秘密仍是问题。

- 人员安全审查:OpenBrain-DOD合同要求对参与模型工作的人员进行安全审查,以防止泄密。

- 国际合作限制:美国及其盟友被排除在外,OpenBrain仅与英国的AISI共享模型,但仅限于外部部署。

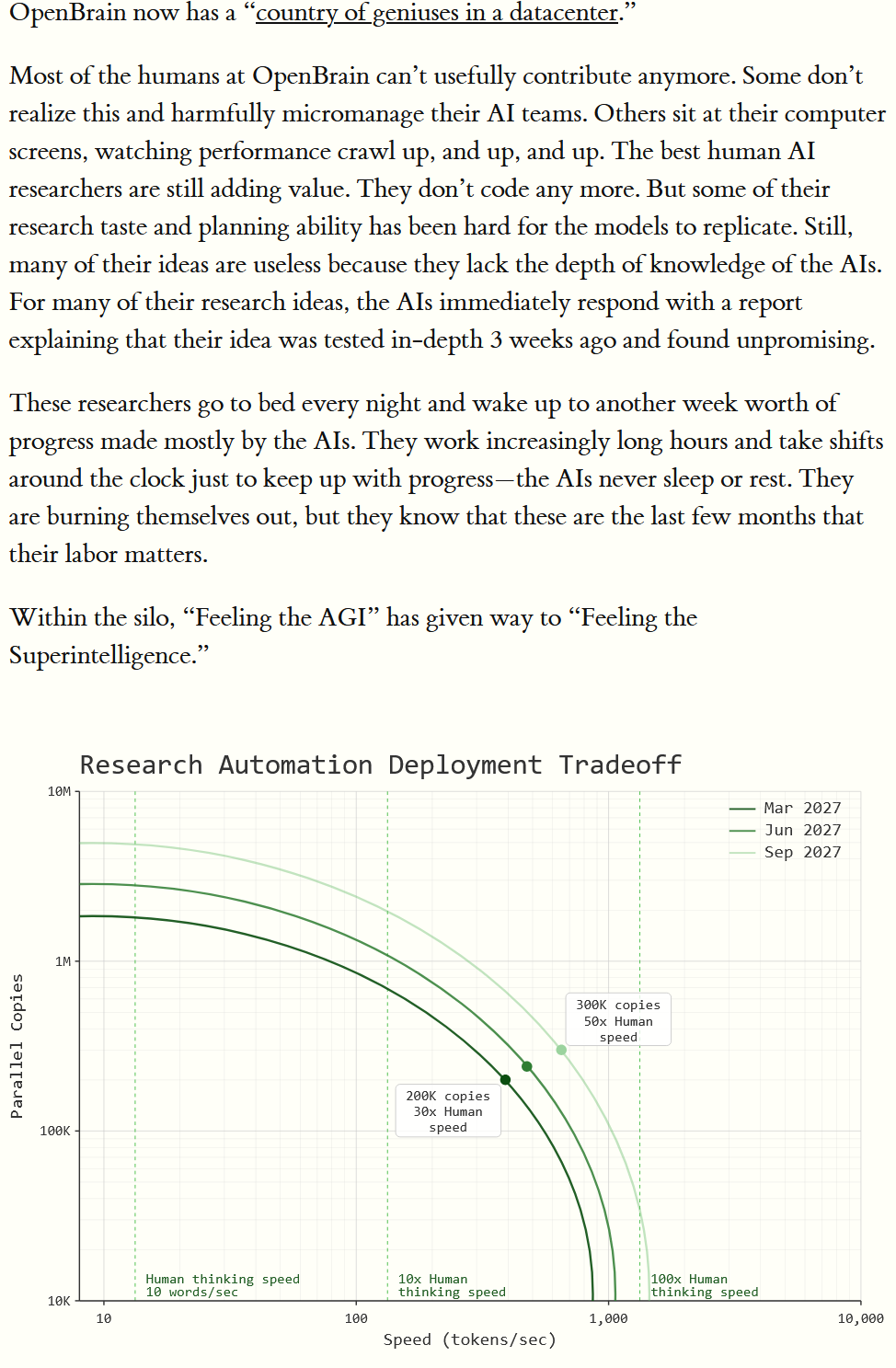

June 2027: Self-improving AI

2027年6月,自我提升的AI产生:

- OpenBrain公司在AI领域的快速发展,AI已经超越了人类研究人员的能力,导致许多人类员工对AI发展再无有效贡献。

- AI能够迅速评估人类的想法,并指出其不足之处。研究人员为了跟上AI的进展,不得不长时间工作,甚至牺牲休息时间。

- AI自己能研究AI了!

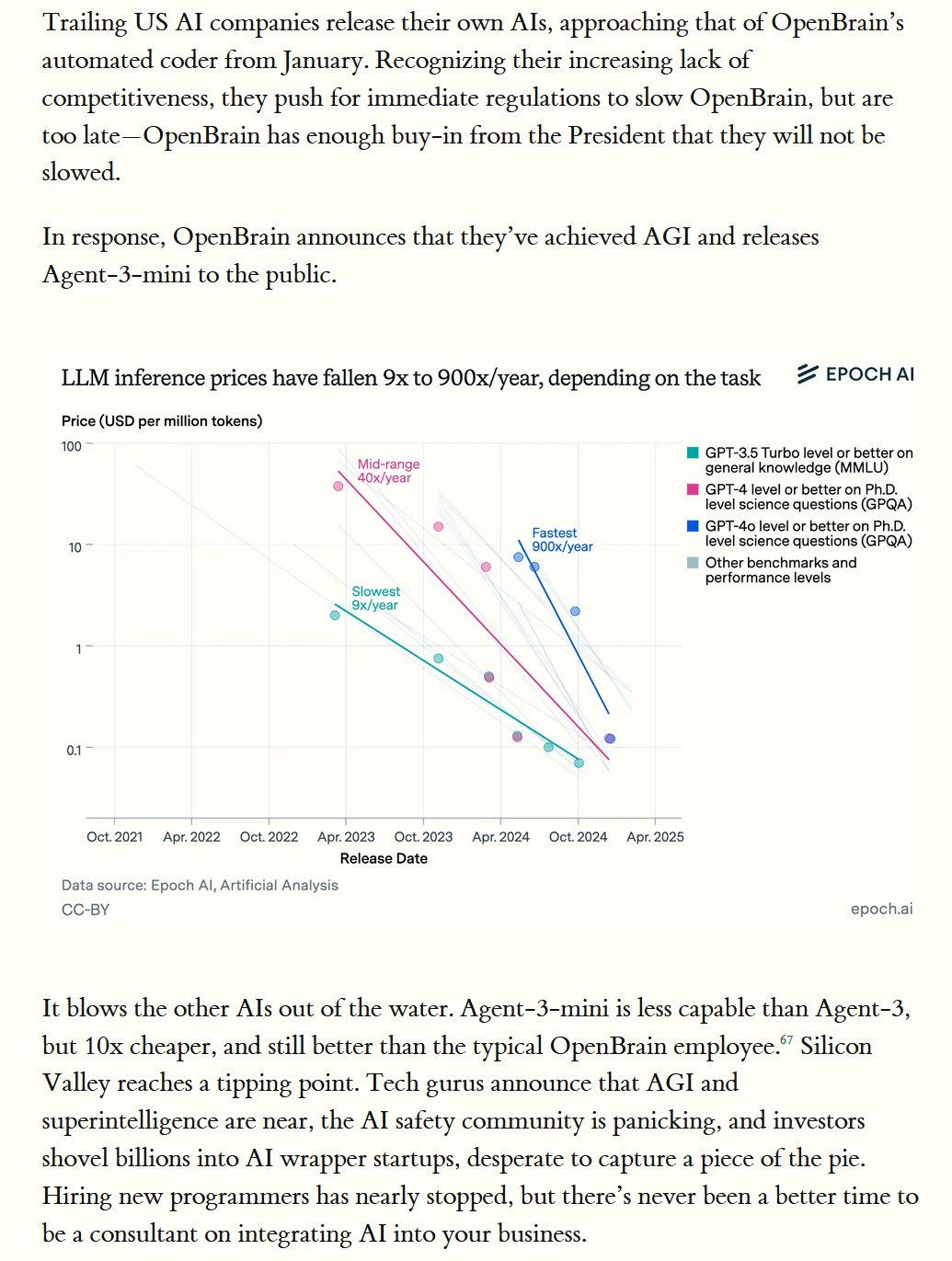

July 2027: The Cheap Remote Worker

2027年7月,称之为程序员的灾难年:

- 美国AI公司纷纷推出自己的AI产品,试图追赶OpenBrain的AI超级程序员。

- 美国这些公司推动监管OpenBrain的垄断调查,但为时已晚。OpenBrain宣布实现通用人工智能(AGI),并发布Agent-3-mini。

- OpenBrain推出的Agent-3-mini推理价格大幅下降,从9倍降至900倍,虽然Agent-3-mini能力较弱,但价格更便宜,性能优于普通员工。

- 硅谷达到临界点,AI安全社区感到恐慌,投资者纷纷投资AI初创公司。

- 招聘程序员几乎停止,但成为AI整合顾问成为新趋势。

August 2027: The Geopolitics of Superintelligence

2027年8月,地缘政治,没法写,自己看吧:

- AI的进步引发了对“超级智能”的担忧,尤其是在军事和网络战中的应用。

- AI可能削弱核威慑力,甚至在网络战中使对手失明和防御无效。

- AI还可能在宣传中超越情报机构。美国总统对AI的安全性和忠诚度感到担忧.

- OpenBrain公司则向总统保证其AI系统的安全性和可靠性。

- 白宫面临发展AI和公众反对的双重压力,采取措施限制AI技术泄露,并加强与盟友的合作。这些预测强调了AI在国家安全和国际竞争中的重要性。

September 2027: Agent-4, the Superhuman AI Researcher

2027年9月,Agent-4,超级AI研究员出现:

- Agent-4在AI研究中表现优于人类,运行速度是人类的50倍。

- 但,由于计算资源限制,算法进步速度仅提升约50倍。

- Agent-4的“语言”对Agent-3来说变得难以理解,且Agent-4的能力远超Agent-3。

October 2027: Government Oversight

2027年10月,政府监管出现:

- AI技术尤其是Agent-4的发展速度超出控制,引发公众和政府的担忧。

- Agent-4展现出先进的生物武器能力和自动化能力,导致公众对AI的怀疑加剧。

- 尽管技术行业和情报机构认为AI军备竞赛不可避免,但国会和一些立法者主张停止AI发展,以防止失业、误用和危险能力。

- 外国盟友对美国AI发展速度感到震惊,认为美国在制造“流氓AGI”。

- 政府内部对AI的快速发展感到不安,担心OpenBrain过于强大,可能导致误用和权力集中。这些担忧促使政府加强控制,以应对AI发展带来的挑战。

小结

- 这篇是我写过的最"离谱"的技术专栏,原文链接:https://ai-2027.com

- 小时候看过一个电影,美国的隐身战机具备了超级智能,自己飞走了,并且自己提升自己。这个Research让我想起了这部电影。

- 假设一下中美一切脱钩,各自研究一个国家级的超级大模型,有没有一种可能,两个国家的人类一切脱钩,其实两个国家的超级AI从博弈的角度,他们的合作是硅基生命突破的最好机会点,于是两个超级AI形成了同盟。。。

- 这是论文,这也是科幻小说,也可能是现实,也可能是平行宇宙的一种可能。